商机详情 -

甘肃智慧园区智慧运维平台

智慧运维平台每日需要处理TB甚至PB级别的海量、多源、异构数据,这离不开现代大数据技术的支撑。平台通常采用分布式存储(如HDFS、对象存储)来经济地存储长期历史数据,利用流处理引擎(如Apache Kafka、Flink)对实时数据进行高吞吐、低延迟的处理与分发,并依托于强大的计算框架(如Spark)进行离线的深度挖掘与模型训练。数据湖架构允许我们以原始格式存储所有运维数据,并在需要时按需定义结构进行计算,这种灵活性极大地增强了对未知问题进行回溯分析的能力,为深度洞察提供了可能。优化调度提高运营效率和服务质量。甘肃智慧园区智慧运维平台

智慧运维平台的价值需要被有效地传递给内部客户(如业务部门)和外部客户。平台可以生成面向不同角色的价值报告:为管理层提供系统整体健康度、资源利用率、成本节省等战略视图;为业务部门提供其关键应用的性能SLA达成情况、用户体验分析等运营视图;甚至可以为重要外部客户提供其使用系统服务的可用性报告。这种透明、量化的价值呈现,增强了运维团队的信誉,促进了IT与业务的深度融合。智慧运维平台的底层,本质上是一个专注于运维领域的数据中台。它将散落在各处的运维数据(日志、指标、追踪、配置信息、工单数据等)进行汇聚、治理、建模和服务化,形成统一、标准、可复用的数据资产。这个运维数据中台不仅服务于实时监控和故障排查场景,更能支撑上层多样的分析应用,如成本分析、安全态势感知、容量规划等。构建运维数据中台,是避免形成新的“智慧孤岛”,实现数据价值比较大化的战略性举措。贵州智慧运维平台供应商Web 端整合挖掘分析运行数据。

智慧运维平台使得运维管理可以从粗放式的“设备可用”升级为精细化的“服务等级目标(SLO)”管理。平台能够基于用户体验数据,自动计算关键业务服务的SLO(如“99.9%的请求响应时间小于200ms”),并实时监控其达成情况。通过“错误预算”的概念,将SLO的消耗情况可视化,为团队的发布节奏和风险决策提供客观依据。当错误预算即将耗尽时,平台会发出预警,促使团队将重心从新功能开发转移到稳定性建设上,实现了业务风险与创新速度的科学平衡。

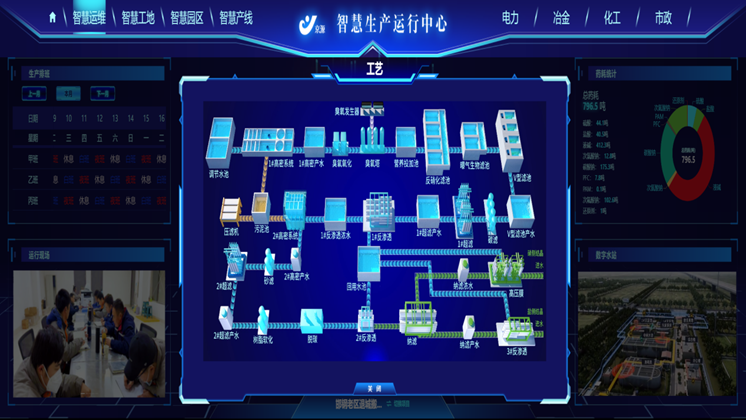

智慧运维平台的成功,高度依赖于输入数据的质量。低质量的数据将导致“垃圾进,垃圾出”的尴尬局面。因此,在平台建设初期就必须建立完善的运维数据治理体系。这包括:制定统一的数据采集标准与规范;建立数据血缘关系,确保数据的可信溯源;对数据进行分类、打标,明确其敏感度和生命周期;清洗和预处理噪声数据、缺失数据。良好的数据治理确保了平台分析结果的准确性和好的性,是构建可靠AI模型的基础,也是平台能否被业务团队信任和采纳的关键。数字大屏模块直观呈现全域项目实时数据。

智慧运维平台的出现,标志着IT运维管理经历了一场深刻的范式变革。传统的运维模式高度依赖人工,运维人员如同“救火队员”,被动地响应各类告警和故障。他们需要登录不同的系统查看日志、监控性能指标,凭借个人经验进行问题定位和根因分析。这种方式不仅效率低下,而且在面对日益复杂的混合IT架构(包括物理机、虚拟机、容器、多云环境)时,往往力不从心,难以预见潜在风险。智慧运维平台的主要突破在于,它通过构建一个统一、集中的数据底座,汇聚了从基础设施、网络、应用到业务层的全栈遥测数据。这改变了以往数据孤岛的局面,为后续的智能分析奠定了坚实基础。它不再是简单的监控工具,而是一个集成了数据采集、处理、分析和可视化的综合性中枢,将运维工作从被动、手工、孤立的模式,展示至主动、自动化、协同的新纪元,这是运维领域从“技艺”走向“科学”的关键一步。

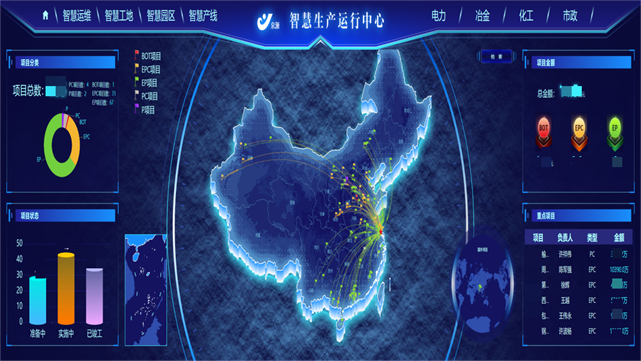

项目状态看板动态呈现全流程转化情况。甘肃智慧园区智慧运维平台

智慧运维平台对传统IT基础设施监控进行了整体智能化升级。它不仅能通过Agent和SNMP等手段采集CPU、内存、磁盘等基础指标,更能利用AI算法为每台服务器、网络设备建立个性化的性能基线。当资源使用率出现违背基线的异常波动时,即使未超过固定阈值,平台也能敏锐捕捉并告警。同时,平台能够关联分析基础设施层与上层应用层的性能数据,快速判断一个应用卡顿是否由底层虚拟机资源争抢引起,实现了从孤立的设备监控到服务于业务体验的全局监控视角转变。甘肃智慧园区智慧运维平台