商机详情 -

上海H100GPU优惠

我理解的就是这些等待的线程在等待的时候无法执行其他工作)也是一个分裂的屏障,但不对到达的线程计数,同时也对事务进行计数。为写入共享内存引入一个新的命令,同时传递要写入的数据和事务计数。事务计数本质上是对字节计数异步事务屏障会在W**t命令处阻塞线程,直到所有生产者线程都执行了一个Arrive,所有事务计数之和达到期望值。异步事务屏障是异步内存拷贝或数据交换的一种强有力的新原语。集群可以进行线程块到线程块通信,进行隐含同步的数据交换,集群能力建立在异步事务屏障之上。H100HBM和L2cache内存架构HBM存储器由内存堆栈组成,位于与GPU相同的物理封装上,与传统的GDDR5/6内存相比,提供了可观的功耗和面积节省,允许更多的GPU被安装在系统中。devicememory:驻留在HBM内存空间的CUDA程序访问的全局和局部内存区域constantcache:驻留在devicememory内的不变内存空间texturecache:驻留在devicememory内的纹理和表面内存空间L2cache:对HBM内存进行读和写servicesmemory请求来源于GPU内的各种子系统HBM和L2内存空间对所有SM和所有运行在GPU上的应用程序都是可访问的。HBM3或HBM2eDRAM和L2缓存子系统都支持数据压缩和解压缩技术。H100 GPU 优惠促销,立刻购买。上海H100GPU优惠

在未来,我们将继续加强与 NVIDIA 的合作,推出更多基于 H100 GPU 的创新解决方案。ITMALL.sale 将不断拓展产品线,满足不同领域客户的需求,并提供更多增值服务,如技术咨询、培训、定制化解决方案等。ITMALL.sale 还将继续优化物流和售后服务体系,提高客户满意度。通过不断创新和提升,ITMALL.sale 致力于成为客户优先的 H100 GPU 供应商,为客户创造更大的价值。ITMALL.sale 的目标是通过持续的技术创新和服务提升,为客户提供更好的产品和服务体验,助力客户业务的成功和发展。NVLINKH100GPU购买H100 GPU 降价特惠,赶快抢购。

H100GPU层次结构和异步性改进关键数据局部性:将程序数据尽可能的靠近执行单元异步执行:寻找的任务与内存传输和其他事物重叠。目标是使GPU中的所有单元都能得到充分利用。线程块集群(ThreadBlockClusters)提出背景:线程块包含多个线程并发运行在单个SM上,这些线程可以使用SM的共享内存与快速屏障同步并交换数据。然而,随着GPU规模超过100个SM,计算程序变得更加复杂,线程块作为编程模型中***表示的局部性单元不足以大化执行效率。Cluster是一组线程块,它们被保证并发调度到一组SM上,其目标是使跨多个SM的线程能够有效地协作。GPC:GPU处理集群,是硬件层次结构中一组物理上总是紧密相连的子模块。H100中的集群中的线程在一个GPC内跨SM同时运行。集群有硬件加速障碍和新的访存协作能力,在一个GPC中SM的一个SM-to-SM网络提供集群中线程之间快速的数据共享。分布式共享内存(DSMEM)通过集群,所有线程都可以直接访问其他SM的共享内存,并进行加载(load)、存储(store)和原子(atomic)操作。SM-to-SM网络保证了对远程DSMEM的快速、低延迟访问。在CUDA层面。集群中所有线程块的所有DSMEM段被映射到每个线程的通用地址空间中。

在大预言模型中达到9倍的AI训练速度和30倍的AI推理速度。HBM3内存子系统提供近2倍的带宽提升。H100SXM5GPU是世界上款采用HBM3内存的GPU,其内存带宽达到3TB/sec。50MB的L2Cache架构缓存了大量的模型和数据以进行重复访问,减少了对HBM3的重复访问次数。第二代多实例GPU(Multi-InstanceGPU,MIG)技术为每个GPU实例提供约3倍的计算能量和近2倍的内存带宽。次支持机密计算,在7个GPU实例的虚拟化环境中支持多租户、多用户配置。(MIG的技术原理:作业可同时在不同的实例上运行,每个实例都有的计算、显存和显存带宽资源,从而实现可预测的性能,同时符合服务质量(QoS)并尽可能提升GPU利用率。)新的机密计算支持保护用户数据,防御硬件和软件攻击,在虚拟化和MIG环境中更好的隔离和保护虚拟机。H100实现了世界上个国产的机密计算GPU,并以全PCIe线速扩展了CPU的可信执行环境。第四代NVIDIANVLink在全归约操作上提供了3倍的带宽提升,在7倍PCIeGen5带宽下,为多GPUIO提供了900GB/sec的总带宽。比上一代NVLink增加了50%的总带宽。第三代NVSwitch技术包括驻留在节点内部和外部的交换机,用于连接服务器、集群和数据中心环境中的多个GPU。。对于开发者来说,H100 GPU 的稳定性和高能效为长时间的开发和测试提供了可靠保障.

我们非常重视客户反馈,并不断改进其服务和产品质量。通过定期回访和客户满意度调查,ITMALL.sale 了解客户在使用 H100 GPU 过程中的需求和建议,及时解决客户遇到的问题。ITMALL.sale 还设有专门的客户服务中心,提供7x24小时的在线支持和电话咨询,确保客户在任何时候都能够获得帮助。ITMALL.sale 的目标是通过不断优化服务,提升客户满意度,成为客户心中值得信赖的 H100 GPU 供应商。ITMALL.sale 的客户服务团队经过严格培训,具备专业的技术知识和良好的服务态度,能够为客户提供的支持和帮助。H100 GPU 适用于智能制造领域。湖南LenovoH100GPU

H100 GPU 在云计算中的应用也非常多。上海H100GPU优惠

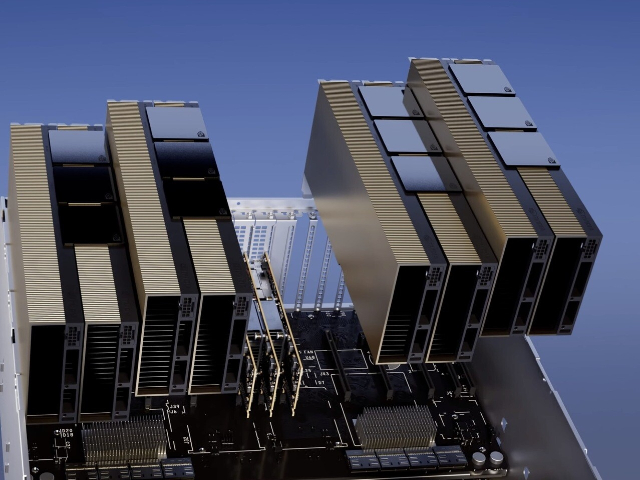

节点内部的每个NVSwitch提供64个第四代NVLink链路端口,以加速多GPU连接。交换机的总吞吐率从上一代的。新的第三代NVSwitch技术也为多播和NVIDIASHARP网络内精简的集群操作提供了硬件加速。新的NVLinkSwitch系统互连技术和新的基于第三代NVSwitch技术的第二级NVLink交换机引入地址空间隔离和保护,使得多达32个节点或256个GPU可以通过NVLink以2:1的锥形胖树拓扑连接。这些相连的节点能够提供TB/sec的全连接带宽,并且能够提供难以置信的一个exaFlop(百亿亿次浮点运算)的FP8稀疏AI计算。PCIeGen5提供了128GB/sec的总带宽(各个方向上为64GB/s),而Gen4PCIe提供了64GB/sec的总带宽(各个方向上为32GB/sec)。PCIeGen5使H100可以与性能高的x86CPU和SmartNICs/DPU(数据处理单元)接口。基于H100的系统和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡内置H100GPU和HMB3内存堆栈提供第四代NVLink和PCIeGen5连接提供高的应用性能这种配置非常适合在一个服务器和跨服务器的情况下将应用程序扩展到多个GPU上的客户。通过在HGXH100服务器板卡上配置4-GPU和8-GPU实现4-GPU配置:包括GPU之间的点对点NVLink连接,并在服务器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch。上海H100GPU优惠