商机详情 -

QatarH100GPU货期

交换机的总吞吐率从上一代的Tbits/sec提高到Tbits/sec。还通过多播和NVIDIASHARP网内精简提供了集群操作的硬件加速。加速集群操作包括写广播(all_gather)、reduce_scatter、广播原子。组内多播和缩减能提供2倍的吞吐量增益,同时降低了小块大小的延迟。集群的NVSwitch加速降低了用于集群通信的SM的负载。新的NVLink交换系统新的NVLINK网络技术和新的第三代NVSwitch相结合,使NVIDIA能够以前所未有的通信带宽构建大规模的NVLink交换系统网络。NVLink交换系统支持多达256个GPU。连接的节点能够提供TB的全向带宽,并且能够提供1exaFLOP的FP8稀疏AI计算能力。PCIeGen5H100集成了PCIExpressGen5×16通道接口,提供128GB/sec的总带宽(单方向上64GB/s),而A100包含的Gen4PCIe的总带宽为64GB/sec(单方向上为32GB/s)。利用其PCIeGen5接口,H100可以与性能高的x86CPU和SmartNICs/DPUs(数据处理单元)接口。H100增加了对本地PCIe原子操作的支持,如对32位和64位数据类型的原子CAS、原子交换和原子取指添加,加速了CPU和GPU之间的同步和原子操作H100还支持SingleRootInput/OutputVirtualization(SR-IOV)。H100 GPU 特惠价销售,快来购买。QatarH100GPU货期

因此线程可以自由地执行其他**的工作。②终线程需要其他所有线程产生的数据。在这一点上,他们做一个"等待",直到每个线程都有"抵达"的信号。-***是允许提前到达的线程在等待时执行**的工作。-等待的线程会在共享内存中的屏障对象上自转(spin)(我理解的就是这些等待的线程在等待的时候无法执行其他工作)也是一个分裂的屏障,但不对到达的线程计数,同时也对事务进行计数。为写入共享内存引入一个新的命令,同时传递要写入的数据和事务计数。事务计数本质上是对字节计数异步事务屏障会在W**t命令处阻塞线程,直到所有生产者线程都执行了一个Arrive,所有事务计数之和达到期望值。异步事务屏障是异步内存拷贝或数据交换的一种强有力的新原语。集群可以进行线程块到线程块通信,进行隐含同步的数据交换,集群能力建立在异步事务屏障之上。H100HBM和L2cache内存架构HBM存储器由内存堆栈组成,位于与GPU相同的物理封装上,与传统的GDDR5/6内存相比,提供了可观的功耗和面积节省,允许更多的GPU被安装在系统中。belarusH100GPU购买H100 GPU 提供全天候的技术支持。

H100GPU架构细节异步GPUH100扩展了A100在所有地址空间的全局共享异步传输,并增加了对张量内存访问模式的支持。它使应用程序能够构建端到端的异步管道,将数据移入和移出芯片,完全重叠和隐藏带有计算的数据移动。CUDA线程只需要少量的CUDA线程来管理H100的全部内存带宽其他大多数CUDA线程可以专注于通用计算,例如新一代TensorCores的预处理和后处理数据。扩展了层次结构,增加了一个称为线程块集群(ThreadBlockCluster)的新模块,集群(Cluster)是一组线程块(ThreadBlock),保证线程可以被并发调度,从而实现跨多个SM的线程之间的**协作和数据共享。集群还能更有效地协同驱动异步单元,如张量内存***(TensorMemoryAccelerator)和张量NVIDIA的异步事务屏障(“AsynchronousTransactionBarrier”)使集群中的通用CUDA线程和片上***能够有效地同步,即使它们驻留在单独的SM上。所有这些新特性使得每个用户和应用程序都可以在任何时候充分利用它们的H100GPU的所有单元,使得H100成为迄今为止功能强大、可编程性强、能效高的GPU。组成多个GPU处理集群(GPUProcessingClusters,GPCs)TextureProcessingClusters(TPCs)流式多处理器(StreamingMultiprocessors。

第四代张量:片间通信速率提高了6倍(包括单个SM加速、额外的SM数量、更高的时钟);在等效数据类型上提供了2倍的矩阵乘加(MatrixMultiply-Accumulate,MMA)计算速率,相比于之前的16位浮点运算,使用新的FP8数据类型使速率提高了4倍;稀疏性特征利用了深度学习网络中的细粒度结构化稀疏性,使标准张量性能翻倍。新的DPX指令加速了动态规划算法达到7倍。IEEEFP64和FP32的芯片到芯片处理速率提高了3倍(因为单个SM逐时钟(clock-for-clock)性能提高了2倍;额外的SM数量;更快的时钟)新的线程块集群特性(ThreadBlockClusterfeature)允许在更大的粒度上对局部性进行编程控制(相比于单个SM上的单线程块)。这扩展了CUDA编程模型,在编程层次结构中增加了另一个层次,包括线程(Thread)、线程块(ThreadBlocks)、线程块集群(ThreadBlockCluster)和网格(Grids)。集群允许多个线程块在多个SM上并发运行,以同步和协作的获取数据和交换数据。新的异步执行特征包括一个新的张量存储加速(TensorMemoryAccelerator,TMA)单元,它可以在全局内存和共享内存之间非常有效的传输大块数据。TMA还支持集群中线程块之间的异步拷贝。还有一种新的异步事务屏障。H100 GPU 提供高效的计算资源利用率。

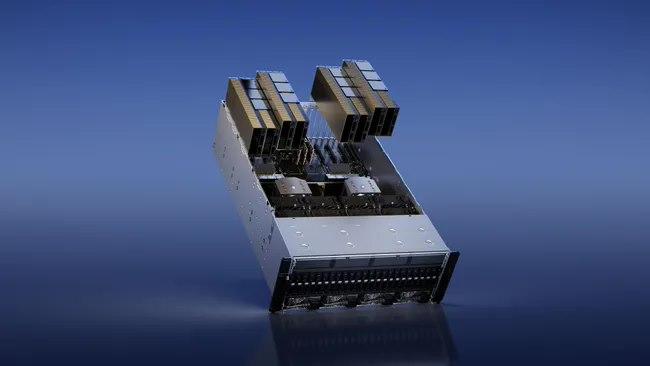

基于H100的系统和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡内置H100GPU和HMB3内存堆栈提供第四代NVLink和PCIeGen5连接提供高的应用性能这种配置非常适合在一个服务器和跨服务器的情况下将应用程序扩展到多个GPU上的客户,通过在HGXH100服务器板卡上配置4-GPU和8-GPU实现4-GPU配置:包括GPU之间的点对点NVLink连接,并在服务器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch,以提供SHARP在网络中的缩减和任意对GPU之间900GB/s的完整NVLink带宽。H100SXM5GPU还被用于功能强大的新型DGXH100服务器和DGXSuperPOD系统中。H100PCIeGen5GPU以有350W的热设计功耗(ThermalDesignPower,TDP),提供了H100SXM5GPU的全部能力该配置可选择性地使用NVLink桥以600GB/s的带宽连接多达两个GPU,接近PCIeGen5的5倍。H100PCIe非常适合主流加速服务器(使用标准的架构,提供更低服务器功耗),为同时扩展到1或2个GPU的应用提供了很好的性能,包括AIInference和一些HPC应用。在10个前列数据分析、AI和HPC应用程序的数据集中,单个H100PCIeGPU**地提供了H100SXM5GPU的65%的交付性能,同时消耗了50%的功耗。DGXH100andDGXSuperPODNVIDIADGXH100是一个通用的高性能人工智能系统。H100 GPU 的单精度浮点计算能力为 19.5 TFLOPS。russiaSMXH100GPU

H100 GPU 支持 CUDA、OpenCL 和 Vulkan 编程模型。QatarH100GPU货期

用于训练、推理和分析。配置了Bluefield-3,NDRInfiniBand和第二代MIG技术单个DGXH100系统提供了16petaFLOPS(千万亿次浮点运算)(FP16稀疏AI计算性能)。通过将多个DGXH100系统连接组成集群(称为DGXPODs或DGXSuperPODs),可以很容易地扩大这种性能。DGXSuperPOD从32个DGXH100系统开始,被称为"可扩展单元"集成了256个H100GPU,这些GPU通过基于第三代NVSwitch技术的新的二级NVLink交换机连接,提供了1exaFLOP的FP8稀疏AI计算性能。同时支持无线带宽(InifiniBand,IB)和NVLINKSwitch网络选项。HGXH100通过NVLink和NVSwitch提供的高速互连,HGXH100将多个H100结合起来,使其能创建世界上强大的可扩展服务器。HGXH100可作为服务器构建模块,以集成底板的形式在4个或8个H100GPU配置中使用。H100CNXConvergedAcceleratorNVIDIAH100CNX将NVIDIAH100GPU的强大功能与NVIDIA®ConnectX-7SmartNIC的**组网能力相结合,可提供高达400Gb/s的带宽包括NVIDIAASAP2(加速交换和分组处理)等创新功能,以及用于TLS/IPsec/MACsec加密/的在线硬件加速。这种独特的架构为GPU驱动的I/O密集型工作负载提供了前所未有的性能,如在企业数据中心进行分布式AI训练,或在边缘进行5G信号处理等。QatarH100GPU货期